GPT-4 y sus novedades

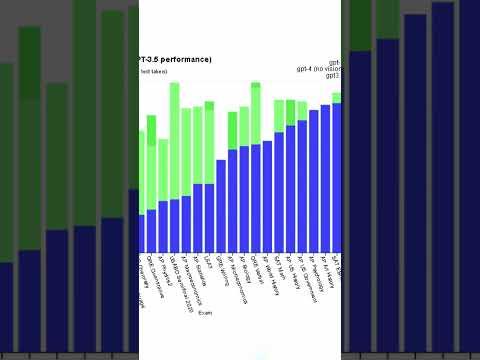

Si con GPT-3 ya tuvimos un Chat que causo mucho revuelo en la comunidad, con el lanzamiento de GPT-4, OpenAI esta tratando de alcazar un nuevo nivel en su modelo de Deep Learning, haciendo que ahora ya no solo pueda procesar Textos como entrada, sino tambien imagenes.

Esto hace que GPT pase de ser un LLM (Large Language Model) a un MLLM (Multi Modal Large Language Model).

Es decir que si antes podías darle al modelo un texto y te podía sacar un resumen de los puntos importantes por ejemplo, ahora también puedes pasarle fotos, screenshots y cualquier imagen en realidad, y puede darte explicaciones detalladas de lo que esta viendo, aun incluso sino le das un contexto de la imagen.

GPT-4 en comparacion con su versión anterior es más confiable, y puede responder preguntas que el modelo anterior no podía, e incluso pudiendo procesar hasta más de 25000 palabras como entrada.

Aunque para poder probar esta nueva API hay una lista de espera [https://openai.com/waitlist/gpt-4-api], o también puedes hacerlo algunas de estas características si ya estas usando Chat-GPT Plus, es decir la versión pagada de Chat-GPT

#gpt4 #gpt3 #openai #ai #machinelearning

Comments are closed.